Neue präzisere 3D-Rekonstruktionen für autonomes Fahren und Denkmalschutz

Von zwei Bildern zum 3D-Objekt

In den letzten Jahren sind neuronale Methoden für kamerabasierte Rekonstruktion sehr beliebt geworden. Diese benötigen allerdings meist hunderte von Kameraperspektiven. Auf der anderen Seite gibt es klassische photometrische Verfahren, die zwar aus wenigen Perspektiven hochpräzise Rekonstruktionen auch aus Objekten mit einer geringen Oberflächentextur berechnen, die aber typischerweise nur in kontrollierten Laborumgebungen funktionieren.

Abbild präziser, trotz weniger Datenpunkte

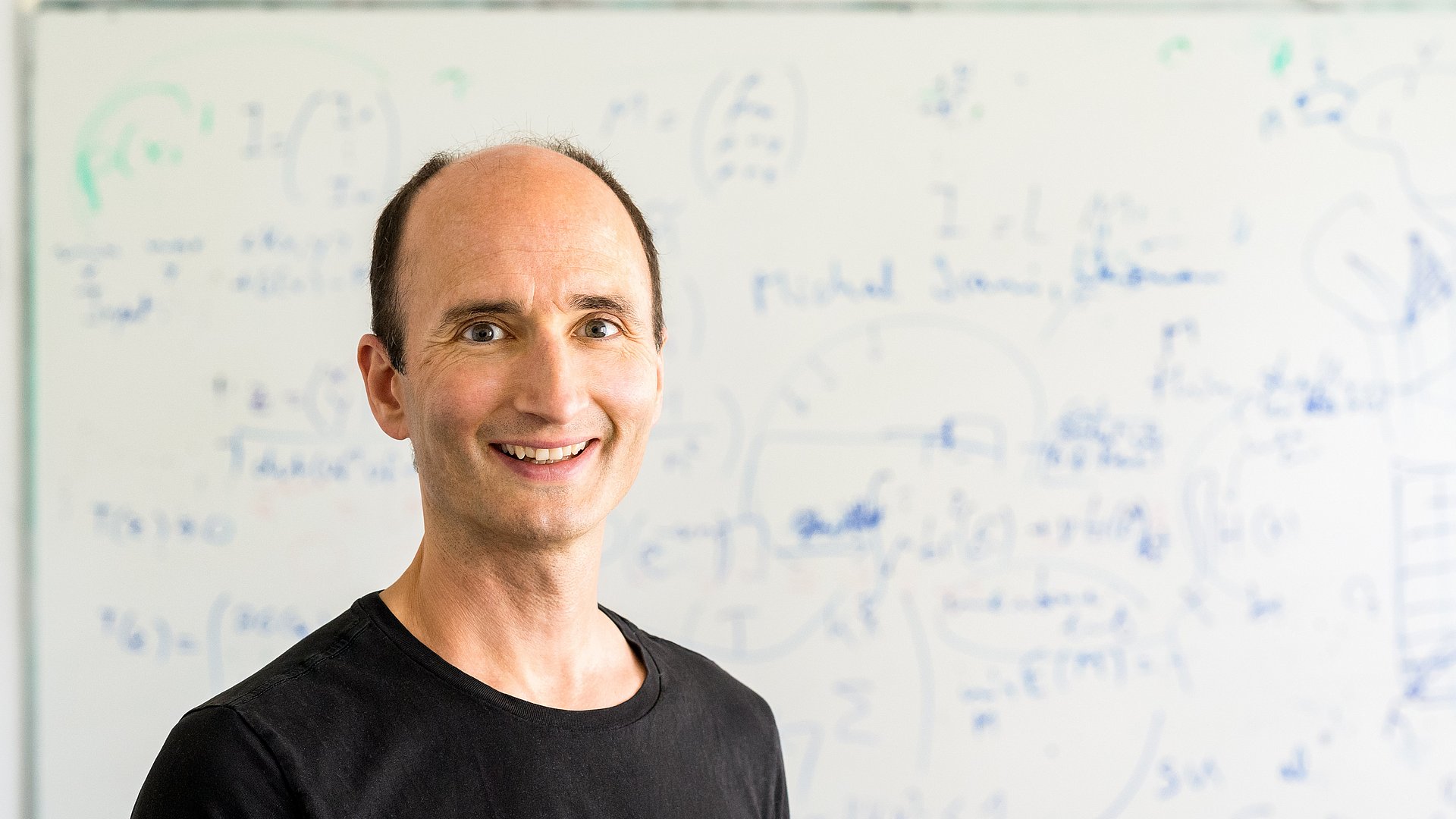

Daniel Cremers, Professor für Bildverarbeitung und Künstliche Intelligenz sowie Leiter des Munich Center for Machine Learning (MCML) und einer der Direktoren des Munich Data Science Institute (MDSI) hat gemeinsam mit seinem Team eine Methode entwickelt, die beide Verfahren verbindet. Die Forschenden kombinieren dafür ein neuronales Netz der Oberfläche mit einem genauen Modell des Beleuchtungsprozesses, das die Abnahme des Lichts mit der Entfernung zwischen Objekt und Lichtquelle berücksichtigt. Dabei kann aus der Helligkeit in den Bildern bestimmt werden, wie die Oberfläche zum Licht ausgerichtet und wie weit sie von der Lichtquelle entfernt ist. „So gelingt es uns, aus wenigen Daten Objekte deutlich präziser nachzubilden, als es bei vorherigen Verfahren möglich war. Für unsere Rekonstruktionen können wir das natürliche Umfeld verwenden und auch Objekte mit nur einer geringen Oberflächentextur nachbilden“, sagt Daniel Cremers.

Anwendung beim autonomen Fahren und Denkmalschutz

Das Verfahren kann genutzt werden, um historische Denkmäler zu erhalten oder Museumsobjekte zu digitalisieren. Werden diese zerstört oder verfallen mit der Zeit, ist es mithilfe von Fotos möglich, diese zu rekonstruieren und wahrheitsgetreu wiederaufzubauen. Neuronale kamerabasierte Rekonstruktionsverfahren entwickelt das Team von Prof. Cremers auch für das autonome Fahren. Hier wird die Umgebung mit einer Kamera gefilmt. Das autonome Auto kann dabei die Umgebung in Echtzeit nachbilden, ein dreidimensionales Szenenverständnis entwickeln und auf Grundlage dessen Entscheidungen treffen. Das Verfahren basiert auf neuronalen Netzen, die für einzelne Bilder eines Videos 3D-Punktwolken der Welt vorhersagen, die dann zu einem großskaligen Modell der durchfahrenen Straßen fusioniert werden.

Künstliche Intelligenz

KI-Anwendungen verändern schon jetzt die Arbeits-, Forschungs- und Alltagswelt. Wir gestalten diesen technologischen Fortschritt mit: Unsere Forschenden entwickeln fächerübergreifend neue Methoden und Anwendungen der KI.

Mohammed Brahimi, Bjoern Haefner, Zhenzhang Ye, Bastian Goldluecke, Daniel Cremers. Sparse Views, Near Light: A Practical Paradigm for Uncalibrated Point-light Photometric Stereo. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2024, pp. 11862-11872.

- Daniel Cremers ist Professor für Bildverarbeitung und Künstliche Intelligenz und gleichzeitig Direktor am Munich Data Science Institute (MDSI) und Munich Center for Machine Learning (MCML). Er erforscht vor allem Methoden der Computer Vision und des Maschinellen Lernens, um Algorithmen für die präzise 3D-Rekonstruktion und Bildanalyse zu entwickeln.

- Die Studie wird auf der Conference on Computer Vision and Pattern Recognition (CVPR) vom 17. – 21. Juni 2024 in Seattle (USA) vorgestellt. Dabei handelt es sich um die wichtigste und größte Veranstaltung auf dem Gebiet der Computer Vision und Mustererkennung.

Technische Universität München

Corporate Communications Center

- Julia Rinner

- presse@tum.de

- Teamwebsite

Kontakte zum Artikel:

Daniel Cremers

Technische Universität München

Professur für Bildverarbeitung und Künstliche Intelligenz

cremers@tum.de